Qwen3-Max-Thinking rivaliza más que nunca con Gemini 3 Pro de Google. La clave está en lo que no se está contando

Hay días en los que da la sensación de que abrimos el móvil y el tablero vuelve a cambiar. Desde que ChatGPT irrumpió en noviembre de 2022, la carrera de la inteligencia artificial no ha dejado de acelerarse, y cada pocas semanas aparece un nuevo modelo que promete empujar un poco más el listón. A veces es una actualización, otras es un “flagship” con un apellido distinto, pero el patrón se repite: más potencia, más ambición y un relato cada vez más global. En ese contexto, China está ganando visibilidad de forma cada vez más evidente, y el nombre que ahora se cuela en la conversación es Qwen3-Max-Thinking, la propuesta de Alibaba con la que quiere jugar en la misma liga que las grandes referencias del momento.

A primera vista, Qwen3-Max-Thinking podría parecer otro nombre más en la lista interminable de modelos. Pero aquí hay un matiz relevante: lo presenta como su modelo estrella para tareas de razonamiento, y lo coloca explícitamente en la misma conversación que Gemini 3 Pro. La compañía asegura que ha escalado parámetros y ha invertido recursos de computación en refuerzo para mejorar varias dimensiones a la vez, desde conocimiento factual y razonamiento complejo hasta seguimiento de instrucciones, alineamiento con preferencias humanas y capacidades de agente. Dicho de otro modo: no está vendiendo solo potencia bruta, sino una forma de “pensar” mejor.

Lo que los benchmarks enseñan

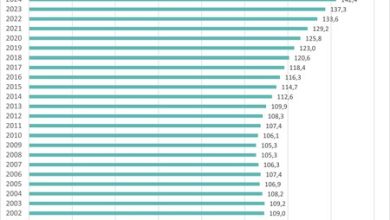

Para aterrizar esa promesa, lo más útil es mirar la tabla comparativa que tenemos entre manos, con 19 benchmarks y un recuento directo: Gemini 3 Pro lidera en 11, Qwen3-Max-Thinking lo hace en 8. Este dato, por sí solo, no decide “quién es mejor”, pero sí ayuda a entender el tipo de pulso que plantea Alibaba cuando lo enfrenta a Google. Aquí merece la pena ser muy literal con lo que estamos midiendo: cada benchmark se centra en una habilidad concreta, desde conocimiento general hasta programación, uso de herramientas, seguimiento de instrucciones o análisis de contexto largo.

Si buscamos el punto donde Qwen3-Max-Thinking aprieta de verdad, hay uno que destaca por encima del resto: el seguimiento de instrucciones y la alineación con lo que los humanos prefieren en una conversación. En Arena-Hard v2, Qwen se impone con 90,2 frente a 81,7 de Gemini, que es la mayor diferencia a su favor en toda la tabla (8,5 puntos arriba). No es un matiz menor, porque este tipo de benchmark no premia solo el “acierto” técnico, sino el resultado final que una persona considera más útil al comparar respuestas a ciegas. A eso se suma IFBench, donde Qwen gana por la mínima (70,9 frente a 70,4). Traducido a la vida real: cuando el usuario no formula una instrucción perfecta, cuando el encargo tiene ambigüedad o exige interpretar intención, Qwen parece más orientado a clavar lo que se le pide y a hacerlo de una forma que se siente natural.

El otro terreno donde Qwen sostiene su narrativa de “modelo pensante” es el razonamiento matemático y la resolución lógica de problemas. En HMMT, tanto en la edición de noviembre de 2025 como en la de febrero de 2025, Qwen queda por delante (94,7 frente a 93,3 y 98,0 frente a 97,5, respectivamente). Y en IMOAnswerBench también gana, aunque por un margen mínimo: 83,9 frente a 83,3. Estos números no sugieren una paliza, pero sí un patrón consistente: cuando el problema exige varios pasos de lógica y no se resuelve solo con memoria o con una respuesta bonita, Qwen tiende a sacar ventaja.

A estas mejoras Alibaba les añade un componente que ya se está convirtiendo en el nuevo estándar: que el modelo no se quede en el texto, sino que pueda actuar. En su presentación, la compañía habla de un uso adaptativo de herramientas que permite recuperar información bajo demanda e invocar un intérprete de código. Y en los benchmarks también aparece esa orientación: en HLE (w/ tools), Qwen se impone con 49,8 frente a 45,8 de Gemini, lo que sugiere una mejor capacidad para desenvolverse cuando el modelo puede apoyarse en herramientas externas. Aquí el cambio de fondo es importante: ya no es solo “qué responde”, sino cómo investiga, cómo decide qué herramienta utilizar y cómo sintetiza lo que encuentra.

Hay una parte de esta comparación donde Gemini 3 Pro se siente más “ingeniero” que “conversador”, y es precisamente donde muchos usuarios profesionales ponen el foco. El modelo de Google gana en MMLU-Pro y MMLU-Redux, dos pruebas muy asociadas a conocimiento general, y también en GPQA y HLE, que en esta tabla aparecen como benchmarks exigentes de evaluación y preguntas complejas. En código, Gemini se impone en LiveCodeBench v6 y también en SWE Verified, lo que refuerza la idea de que, para tareas de programación, sigue siendo una apuesta muy sólida. A eso se suma AA-LCR, donde lidera en análisis de documentos largos.

La letra pequeña se esconde más allá del precio

Llegados a este punto, hay una pregunta que pesa tanto como cualquier benchmark: cuánto cuesta usar estos modelos en serio. En precios estándar por 1M de tokens, el contraste es claro. En Gemini 3 Pro, la entrada se mueve entre 2 y 4 dólares según el tramo de tokens de entrada, mientras que en Qwen3-Max el input figura en 1,2 dólares. Pero la diferencia más importante aparece en la salida, que es donde se paga el “pensamiento” del modelo: Gemini marca 12 a 18 dólares frente a los 6 dólares de Qwen. Traducido en proporciones, en uso estándar Gemini es aproximadamente 1,67 veces más caro en entrada y 2 veces en salida en el tramo habitual. Si el tramo supera los 200.000 tokens de entrada, la distancia sube a 3,33 veces en entrada y 3 veces en salida.

Gemini es aproximadamente 1,67 veces más caro en entrada y 2 veces en salida en el tramo habitual.

Y aquí llegamos a la parte que suele quedar fuera de la conversación cuando todo se centra en potencia y precio: qué pasa con tus datos cuando usas el modelo, y bajo qué reglas. En el caso de Qwen, hay que separar claramente dos mundos. Por un lado está el chat web de consumo, cuyos términos contemplan el uso y almacenamiento del “contenido de Usuario” para desarrollar y mejorar tecnologías de IA, incluyendo contenido desidentificado, y la posibilidad de procesarlo para nuevos productos y servicios. Además, al menos en nuestra revisión, no hemos encontrado un control claro o una opción visible que permita desactivar ese uso. Por otra parte, en el material revisado no aparece una referencia explícita a la UE ni al RGPD. En su política de privacidad, Alibaba advierte de transferencias internacionales de datos y señala que el servicio se presta generalmente desde Singapur y que los datos suelen procesarse en Singapur, Indonesia y o China.

Alibaba, eso sí, introduce matices importantes. El entorno profesional Alibaba Cloud asegura que no usa los datos para entrenamiento y que cifra la información con AES-256. También explica que el tratamiento de las conversaciones cambia según el tipo de uso: en llamadas directas por API no se guardan, mientras que en otros modos sí puede conservarse historial para mejorar la experiencia. Google introduce un matiz comparable: con Gemini API de pago, los prompts y respuestas no se usan para entrenar modelos y se tratan como confidenciales. A ese marco debemos señalar otro elemento de contexto: la Ley de Inteligencia Nacional china, en su artículo 7, establece que organizaciones y ciudadanos deben, conforme a la ley, “apoyar, asistir y cooperar” con el trabajo de inteligencia nacional, manteniendo además el secreto sobre lo conocido, una obligación legal que ha generado preocupaciones en la Unión Europea y en otras partes del mundo.

Imágenes | Xataka con Gemini 3 Pro | Captura de pantalla