Las TPUs de Google son la primera gran señal de que el imperio de NVIDIA se tambalea

Era 2013 y Jeff Dean, uno de los directivos de Google, se dio cuenta de algo junto a su equipo: si cada usuario de Android usara su nueva opción de búsqueda por voz durante tres minutos al día, la empresa tendría que doblar el número de centros de datos para hacer frenta a la carga computacional. En aquel momento Google usaba CPUs y GPUs estándar para dicha tarea, pero entraron en pánico y se dieron cuenta de que necesitaban crear sus propios chips para esas tareas.

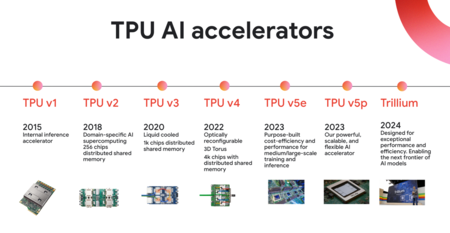

Así nació la primera Tensor Processing Unit (TPU) de Google, un ASIC específicamente diseñado para ejecutar las redes neuronales que potenciaban sus servicios de voz. Aquello creció y creció y en 2015, antes de que el mundo lo supiera, aquellas primeras TPUs aceleraban Google Maps, Google Photos y Google Translate. Una década después Google ha creado TPUs tan potentes que se han convertido casi sin quererlo en una sorprendente e inesperada amenaza para la todopoderosa NVIDIA. Ahí es nada.

Bendito pánico.

Las TPUs de Google cumplen su promesa

Hasta ahora cuando una empresa de IA quería entrenar sus modelos, acudía a los chips avanzados de NVIDIA. Eso ha cambiado en los últimos tiempos, y de hecho hemos visto dos señales recientes que desde luego plantean un punto de inflexión.

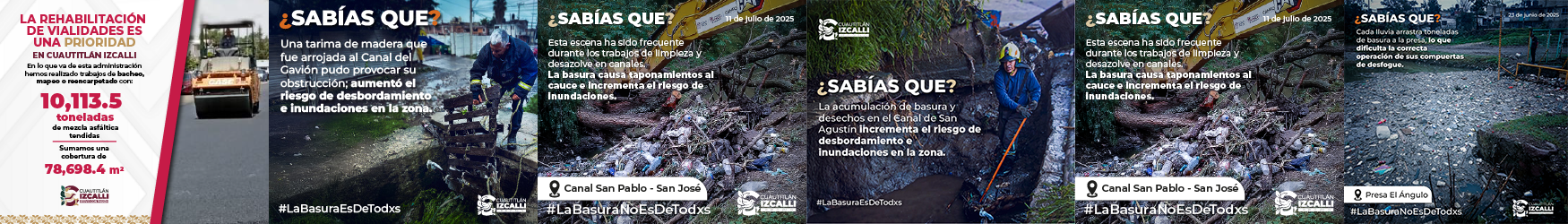

En esa línea de tiempo falta el último y más llamativo integrante de esta familia, Ironwood, presentado en abril de 2025. Fuente: Google.

La primera el lanzamiento de Claude Opus 4.5, un modelo excepcional, especialmente en tareas de programación. Los responsables de Anthropic ya explicaron que este nuevo modelo no depende solo de NVIDIA, sino que combina la potencia de tres propuestas distintas: la de NVIDIA, pero también los Trainium de Amazon y las TPUs de Google.

Pero es que además Google ha dado la campanada por que su nuevo y flamante modelo de IA Gemini 3 ha sido exclusivamente entrenado usando las nuevas TPUs Ironwood que se presentaron en abril y que se han convertido en una verdadera sensación.

Como decíamos, Google inició ese proyecto en 2013 y lanzó su primera TPU en 2015, pero aquella necesidad interna se convirtió en una bendición, porque lo que Google no podía saber es que esas TPUs acabarían llegando en el momento justo: el lanzamiento de ChatGPT las convirtió en una fantástica oportunidad para fortalecer su infraestructura de IA, pero también para ser usadas para entrenamiento e inferencia de sus modelos de IA.

De ahí acabamos llegando a las TPUs Ironwood actuales, que en su séptima generación son excepcionales tanto en inferencia como en entrenamiento (como ha demostrado su uso para Gemini 3).

Google ha logrado exprimir aun más sus chips y ha doblado el pico de FLOPS por vatio respecto a su generación anterior. Fuente: Google.

La eficiencia y potencia de estos chips da un salto muy notable respecto a sus predecesores, y por ejemplo logran doblar el rendimiento de FLOPS por vatio que se conseguía con los chips Trillium.

Si los comparamos con los TPU v5p de 2023, los chips loogran alcanzar los 4.614 TFLOPS, 10 veces más que los 459 TFLOPS de aquellos modelos de hace dos años. Es un salto extraordinario en rendimiento (y eficiencia).

La clave de 2025: Google ahora deja que otros usen sus TPUs

Pero es que en la evolución de las TPUs hay otro elemento diferencial en 2025. Este ha sido el año en el que Google ha dejado de «ser egoísta» con sus TPUs. Antes solo ella podía usarlas, pero en los últimos meses ha llegado a sendos acuerdos con OpenAI —que también busca fabricar sus propios chips— y sobre todo con Anthropic.

El rendimiento de Ironwood es ya comparable al de los GB200 e incluso al de los GB300 de NVIDIA. Fuente: SemiAnalysis.

Esa segunda alianza es especialmente monumental como parte de esa estrategia de externalización. Google no solo está alquilando capacidad en su nube, sino facilitando la venta física de hardware. El acuerdo abarca un millón de TPUs: 400.000 unidades de su TPUv7 Ironwood vendidas directamente a través de Broadcom, y 600.000 alquiladas a través de Google Cloud (GCP).

En un profundo informe en SemiAnalysis se revela cómo desde una perspectiva técnica, la TPUv7 Ironwood es un competidor formidable. La brecha de rendimiento con NVIDIA se está cerrando, y la TPU de Google prácticamente igual al chip Blackwell de NVIDIA en FLOPS y ancho de banda de memoria.

Sin embargo la ventaja real reside en el coste. El Total Cost of Ownership (TCO) de un servidor Ironwood es según sus estimaciones un 44% menor para Google que para un servidor GB200 de NVIDIA, lo que permite al gigante de las búsquedas ofrecer precios muy competitivos a clienes como Anthropic.

Para ayudar aún más en esa carrera, señalan en SemiAnalysis, Google tiene otro as en la manga. Se trata del Inter-Chip Interconnect (ICI) de Google, una arquitectura de red que permite conectar hasta 9.216 chips Ironwood usando una topología de toro 3D.

Google además usa conmutadores de circuito óptico que permiten enrutar datos ópticos sin conversión eléctrica, reduciendo tanto la latencia como el consumo de energía. Eso permite reconfigurar la topología de esa red sobre la marcha para evitar (o mitigar) fallos y optimizar distintos tipos de paralelismo.

El «foso» de NVIDIA con CUDA se va estrechando

Hemos repetido frecuentemente que aunque los fabricantes de semiconductores cuentan ya con chips llamativos —que se lo digan a AMD— en realidad la verdadera fortaleza de NVIDIA está en CUDA, la plataforma software que se ha convertido en el estándar de facto para desarrolladores e investigadores de IA.

Google también quiere cambiar aquí las cosas. Durante los últimos años la empresa trató de centrarse en las librerías Python como JAX o XLA, pero en los últimos tiempos ha comenzado a priorizar el soporte nativo de PyTorch —gran competidor de TensorFlow— en sus TPUs.

Eso es crucial para facilitar que ingenieros y desarrolladores comiencen a migrar a sus TPUs en lugar de las GPUs de NVIDIA. Antes era posible usar PyTorch en las TPUs, pero era incómodo, como si uno tuviera que hablar un idioma usando un diccionario en tiempo real, mientras que para las GPUs de NVIDIA ese era el idioma «materno».

Con XLA Google utilizaba una librería intermedia a modo de traductor para poder usar PyTorch, pero eso era una pesadilla para desarrolladores. El soporte nativo permite que a los ojos del desarrollador, las TPUs de Google se comporten igual que las GPUs de NVIDIA.

El otro gran avance que está realizando Google en el apartado software va orientado al soporte de ecosistemas de inferencia abiertos. Aquí vLLM y SGLang son como un motor de alto rendimiento para un coche de carreras: estas librerías software permiten ejecutar modelos de IA de forma eficiente y barata, y corrían de serie en GPUs de NVIDIA.

La solución de Google para poder usar vLLM era de nuevo coger ese código y traducirlo en tiempo real a JAX, algo que era ineficiente. No había optimización, pero Google está atajando ese problema con un grupo de trabajo que de nuevo plantea un soporte mucho más «nativo» en las TPUs de Google. Esto de momento está en pleno desarrollo, pero está destinado también a «estrechar el foso» (moat) que NVIDIA posee y que es una baza importante para seguir dominando en este mercado.

Estamos pues ante un potencial cambio de tornas en el mundo de los fabricantes de chips de IA. La situación actual de Google lo coloca claramente como la amenaza más seria para NVIDIA hasta la fecha.

Ya no estamos ante un proveedor de infraestructura en la nube que optimiza sus propias cargas de trabajo, sino ante una empresa que vende soluciones completas y que ofrece mejor rendimiento por dólar, una escala de red superior y una prometedora hoja de ruta en el terreno del software.

NVIDIA tiene problemas, desde luego. Veremos cómo reacciona.

En Xataka | El problema de AMD no es que no haga buenas GPUs para IA. Es que ni aún así está cerca de NVIDIA