Creíamos que ningún modelo abierto podría superar a GPT-5. Una startup china demuestra que estábamos equivocados

Una startup china llamada Moonshot acaba de lanzar Kimi K2 Thinking, un gigantesco modelo abierto con un billón de parámetros que ha hecho algo que parecía casi imposible: superar a los mejores modelos propietarios de empresas como OpenAI, Google o Anthropic. Si creíamos que los modelos «Open Source» jamás podrían competir con GPT-5, Gemini 2.5 Pro o Claude, estábamos equivocados.

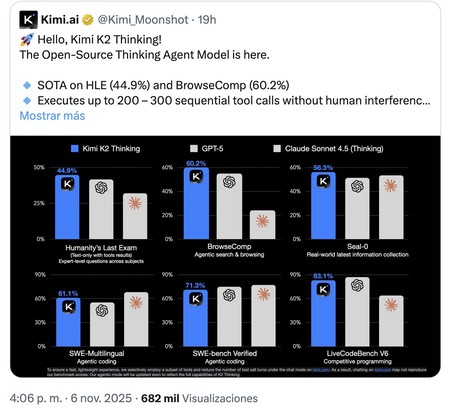

Qué ha pasado. Este «laboratorio de IA» ya había anunciado Kimi K2 en julio con ese tamaño gigantesco de un billón de parámetros, pero ahora han lanzado la versión «Thinking» con ese mismo tamaño (32.000 millones de parámetros activos, arquitectura Mixture of Experts). Según sus responsables, el modelo es capaz de mantener un uso estable de herramientas agénticas a lo largo de entre 200 y 300 llamadas secuenciales. O lo que es lo mismo: puede encadenar largas secuencias de acciones de forma autónoma y aparentemente sin error. Lo mejor de todo no es eso: es que supera a GPT-5 o Claude Sonnet 4.5 en diversas pruebas y cuesta mucho menos que esos modelos.

Los benchmarks. Los responsables de Moonshot explicaban cómo Kimi K2 Thinking logra las puntuaciones más altas en Humanity’s Last Exam (conocimientos generales, 44,9%) y en BrowserComp (navegadores agénticos, 60,2%). Está casi al nivel de Claude en el test de desarollo software SWE, y también es casi el mejor en otro de esos benchmarks, LiveCodeBench v6. Es cierto que en algunos test sigue estando ligeramente por detrás de sus rivales «occidentales», pero el logro es espectacular.

Más benchmarks. Los responsables de Artificial Analysis han mostrado sus primeras conclusiones tras evaluarlo con diversas pruebas. Así, destacan su comportamiento en tareas agénticas que simulan que el modelo está actuando como un agente de servicio de atención al cliente. En dicha prueba obtuvo un 93% del máximo, superando a todos sus competidores de largo (GPT-5 Codex High obtuvo un 87%, por ejemplo). Harán más pruebas, pero de momento las perspectivas son fantásticas.

Y encima, barato. En CNBC indican que entrenar el modelo costó 4,6 millones de dólares, una cifra ridícula teniendo en cuenta que entrenar modelos propietarios como GPT-5 costó unos 500 millones de dólares según las estimaciones. Usar la API de Kimi K2 Thinking es además muy asequible: 0,6 dólares por millón de tokens de entrada y 2,5 dólares por millón de tokens de salida. GPT-5 Chat cuesta 1,25/10 dólares respectivamente, mientras que Claude Sonnet 4.5 cuesta 3/15 dólares respectivamente.

Los detalles. El modelo hace uso de un cuantización INT4 para mejorar su eficiencia sin comprometer apenas la precisión y calidad de sus respuestas. Su ventana de contexto —el «tamaño» de los datos que podemos introducir al realizar prompts— es de 256k, una cifra relativamente modesta para los grandes modelos pero aún así notable. Y como buen modelo abierto, podemos descargarlo para usarlo en local… si tenemos un verdadero monstruo a nuestra disposición. El modelo pesa 594 GB, y por ejemplo uniendo dos Mac Studio M3 Ultra es posible lograr hacerlo funcionar en local de forma relativamente fluida a unos 15 t/s.

Alibaba está detrás. Aunque el modelo está desarrollado por una startup independiente llamada Moonshot, dicha firma ha sido apoyada económicamente por Alibaba, que se está convirtiendo en una absoluta potencia en este ámbito. Ya no solo se conforma con desarrollar sus propios modelos, que son sobresalientes (Qwen es el claro ejemplo), sino que además está financiando el desarrollo de otros modelos como Kimi K2/Thinking.

China y su amor por los modelos de IA abiertos. Durante los últimos meses hemos comprobado como China dominaba en el ámbito de los modelos de IA abiertos —que no «Open Source»—. El gigante asiático ha adoptado una filosofía arrolladora con modelos cada vez mejores pero que hasta ahora parecían ir varios pasos por detrás de los grandes modelos propietarios de OpenAI, Anthropic o Google. Esto ya no es así.

La carrera se anima. Este logro supone un nuevo voto de confianza para los modelos abiertos que llegan de empresas chinas. Es cierto que son enormes y eso hace muy difícil usarlos en la práctica por parte de usuarios finales, pero plantean una interesante alternativa para empres

Imagen | idnaklss con Midjourney